Deuxième document :

Une trace de mes travaux et de mes jours

|

1.

L'aventure d'un lecteur

J'ai toujours conservé dans ma bibliothèque quelques livres que j'avais, adolescent, lus et relus sans les comprendre parfaitement : L'évolution des idées en physique d'Albert Einstein et Léopold Infeld [2] , ainsi que Matière et lumière [3] puis Continu et discontinu en Physique moderne [4] de Louis de Broglie.

J'avais découvert le premier de ces ouvrages pendant l'hiver 39-40, celui de la "drôle de guerre" (j'étais alors élève de Math. Elem. au lycée d'Alençon). Je m'étais surtout intéressé à la description de la naissance et du déclin de la "conception mécanique" ainsi qu'à la célèbre "expérience de pensée" dans l'ascenseur en chute libre. J'avais apprécié la clarté du Chapite IV (les quanta) qui donnait une présentation succinte de «l'ouvre de Bohr, de De Broglie, de Schrödinger, de Heisenberg, de Dirac et de Born» (cf. 2, p.279) et insistait sur le caractère "probabiliste" de la théorie. Mais je n'avais pas prêté une attention particulière aux réserves formulées vers la fin du chapitre (pp. 285-6), réserves qu'il me semble intéressant de reproduire ici :

Il est hors de doute que la physique quantique a expliqué une très riche variété de faits et qu'elle a abouti, pour la plus grande partie, à un accord éclatant entre la théorie et l'observation. La nouvelle physique quantique nous éloigne encore davantage de l'ancienne conception mécanique et un retour à la position antérieure semble, plus que jamais, invraisemblable. Mais il n'y a pas de doute que la physique quantique doit toujours être basée sur les deux concepts de matière et de champ. Elle est, en ce sens, une théorie dualiste et ne fait pas avancer même d'un pas notre vieux problème de ramener tout au concept de champ.Le développement se fera-t-il le long de la ligne choisie par la physique quantique, ou est-il plus probable que de nouvelles idées révolutionnaires seront introduites en physique? La route du progrès tournera-t-elle de nouveau brusquement, comme elle l'a fait si souvent dans le passé?Durant ces dernières années toutes les difficultés de la physique quantique se sont concentrées autour d'un petit nombre de points principaux. La physique attend impatiemment leur solution. Mais il n'y a pas moyen de prévoir quand et où l'éclaircissement de ces difficultés sera réalisé.

J'achetai les livres de de Broglie à leur parution (ou réédition), en janvier et avril 1941 (j'étais alors en "hypotaupe" au Lycée Buffon et je participai à la diffusion de L'étudiant patriote au sein d'une équipe animée par Jacques Baudry). Je n'aperçus pas alors les réticences de l'auteur relativement aux problèmes d'interprétation - réticences qui faisaient sans doute écho aux positions qu'il avait défendues dès 1923, mais abandonnées après 1927. Par contre je fus intrigué par les remarques (cf. 3, p. 235) relatives

"... au problème de la réconciliation des Quanta et de la Relativité. La théorie de la Relativité constitue en somme le couronnement de l'ancienne théorie macroscopique tandis qu'au contraire la théorie des quanta a surgi de l'étude du monde coropusculaire et atomique. Étant si différentes d'origine, il n'est pas surprenant que leur conciliation exige un sérieux effort. A l'heure actuelle, si peu de temps après le développement tumultueux des doctrines quantiques, il est naturel que cette conciliation ne soit pas encore faite de façon satisfaisante.

Ces observations sont renforcées dans le texte de 1941 (cf. 4 pp.194-203) où, après avoir présenté la théorie de Dirac dans laquelle la fonction d'onde est une grandeur mathématique à quatre composantes obéissant à une équation aux dérivées partielles qui possède l'invariance relativiste, de Broglie examine une des difficulté d'interprétation qui subsistent

... Cette difficulté semble se rattacher par un lien étroit à cette sorte de structure fibreuse de l'espace-temps dans le sens du temps due, nous l'avons vu à ce que la persistance des unités matérielles se traduit dans l'espace-temps par l'existence de faisceaux de lignes inclinées de moins de 45° sur l'axe du temps.

Pendant l'hiver 1942, étudiant bigame (Sciences et Lettres) à la Sorbonne, je m'escrimai sur le livre de Dirac, Les principes de la Mécanique quantique, dont j'avais trouvé la traduction française (de Proca et Ullmo) chez Gibert . L'approche très "fondamentale" adoptée par Dirac m'enchantait mais je n'arrivais vraiment pas à en maîtriser le formalisme, trop abstrait pour moi. En 1943 je connus une sorte de crise psychologique un peu semblable à celles décrites par Roussel [5] : je suivais alors l'enseignement que Marie-Antoinette Tonnelat donnait au Collège de France dans le cadre de la Fondation Peccot, cours consacré aux théories unitaires de l'Electromagnétisme et de la Gravitation, en particulier aux modèles de Kaluza et Klein. Un soir, dans une sorte de transe, je crus découvrir une explication relativiste des phénomènes de quantification en imaginant une modélisation géométrique du processus de la connaissance. Celle-ci, se déployant dans un espace euclidien, ne pouvait "coller" à une réalité nécessairement décrite dans le cadre d'un espace "courbe" comme celui que proposait la relativité générale - ou plutôt l'adéquation ne pouvait être que locale, progressant par décollages et recollages successifs, distribués aléatoirement en raison de la la complexité des phénomènes en cause! Ce n'était évidemment que métaphore, un rêve dans un Paris travaillé par le froid et la faim!

J'abandonnai bientôt ce rêve

et me tournai résolument vers la Logique; mais le professeur titulaire,

Jean Cavaillès, était "empêché" (je ne compris pourquoi qu'à

la Libération), et je devins l'élève de Bachelard dont le cours, cette

année-là, était d'ailleurs consacré à la Relativité restreinte. L'enseignement

de la Logique était assuré par Jean-Louis Destouches, un jeune auteur

très proche de Louis de Broglie et qui, après avoir tenté une axiomatisation

générale de la Physique (tentative trop ambitieuse, sans doute) [6] , s'était orienté, avec Paulette

Février, vers l'analyse logique des problèmes de la mesure et du principe

de complémentarité [7] . Je lui dois d'avoir été invité,

en 1944, à présenter à l'Institut Henri Poincaré, dans le cadre du séminaire

Bachelard, un exposé sur "L'unité des disciplines".

2. Brisure à senestre

Après la Libération je me livrai à diverses activités alimentaires (agent

technique au service de la censure du Ministère de l'Intérieur, pianiste

dans un salon de thé, place de l'Odéon, etc...). Bachelard avait accepté

de diriger une thèse dont je lui avais soumis le projet Sur le fondement

des Mathématiques, thèse que je concevais comme un prolongement

des analyses de Jean Cavaillès et d'Albert Lautman; mais, en dépit de

son soutien et de celui de la commission de spécialistes, le CNRS refusa

par deux fois la bourse que je sollicitai. J'acceptai donc - sur la

suggestion de Jacques Labeyrie, et comme une solution provisoire avant

de trouver un emploi dans un service de recherche - le poste de bibliothécaire

au sein du service de Documentation du Commissariat à l'Energie Atomique,

service créé et dirigé par Marie-Elisa Cohen-Nordmann. C'était en mars

1949.

Mon travail me permit de faire la connaissance de nombreux jeunes chercheurs et de quelques aînés qui avaient fait leurs débuts chez Joliot ou Langevin comme Jules Guéron, Maurice Surdin ou André Berthelot. Nous étions alors au fort de Châtillon où Jules Horowitz et Anatole Abragam partageaient un bureau à côté du mien; je me liai d'amitié avec Jacques Pottier et, un peu plus tard, avec Christophe Tzara et Pierre Lehmann. Avec leur aide, j'organisai un séminaire sur la théorie de l'information, où l'on discutait les publications récentes de Wiener, Shannon, Moyal, Ville, etc... Nous nous intéressions en particulier au problème du "bruit de fond" électronique, problème pour lequel Maurice Bernamont, un élève de Langevin avait accompli, avant la guerre, un travail de pionnier. Surdin avait préparé une thèse dans ce domaine sous sa direction [8] . Nous devînmes donc familiers avec les techniques mathématiques associées à la description des processus stochastiques : processus de Poisson, de Markov, processus stationnaires, théorème de Wiener-Khintchine, etc...

A la Libération j'avais appris la mort de Jacques Baudry (celle aussi de Jean Cavaillès). Je décidai (encouragé par Albert Camus auquel Jean Paulhan m'avait présenté) de confirmer mon engagement politique dans le mouvement de la Jeunesse Communiste, puis de l'U.J.R.F. qui lui succéda [9] . Mes débuts dans la vie professionnelle ne diminuèrent pas mon zèle militant. A cette époque la plupart des activités culturelles, à Paris et en province, étaient animées par des communistes avec Arts de France, L'Écran Français, Les Lettres Françaises, La Pensée, etc...

Mais à partir de 1947, le large consensus qui règnait depuis la libération fut remis durablement en cause à l'occasion de la polémique déclenchée par Jdanov et du débat : "science bourgeoise versus science prolétarienne" [10] qui fit alors rage. On notera que l'écho des encycliques jdanoviennes ne retentit guère en France avant l'intervention de Laurent Casanova devant les intellectuels communistes, en 1949 et les conséquences dans le domaine de la physique ne se firent sentir qu'au début des années 50. A vrai dire, je n'étais qu'à-moitié convaincu par les arguments présentés par les jdanoviens français officiels (qui s'exprimaient essentiellement dans La nouvelle critique). Admirateur d'Alfred Jarry, de Raymond Roussel, de Marcel Duchamp et de Tristan Tzara, j'étais devenu l'ami de Boris Vian, et de Raymond Queneau. Je n'étais donc guère porté à rompre des lances contre le soi-disant "art bourgeois" et le zèle incantatoire de Jean Desanti, de Gérard Vassails et de Pierre Daix m'agaçait passablement malgré le grand respect que j'éprouvais pour l'intelligence de Laurent Casanova (qui, après bien d'autres, devait connaître une brutale disgrâce en 1961).

Mais le statut philosophique

de la théorie quantique m'avait toujours laissé perplexe et, dans ce

domaine précis, j'étais prêt à me joindre à la contestation. Celle-ci

prit d'ailleurs un tour nouveau lorsque Jean-Pierre Vigier observa la

parenté du modèle aux "variables cachées" de David Bohm avec

une théorie proposée par de Broglie en 1923. Vigier était consultant

au C.E.A. et j'eus d'intéressantes discussions avec lui ainsi qu'avec

André Régnier qui préparait une thèse sur les processus stochastiques

et leurs équations de diffusion. Mon activité de bibliothécaire me permettait

en même temps de prendre connaissance des travaux de Fenyès, Novobatsky,

et autres non-orthodoxes - mais aussi de découvrir les textes sources

de la physique quantique.

3. Conversations dans le département de Seine-et-Oise

En 1950 je rencontrai deux physiciens qui travaillaient avec Frédéric

Joliot au Collège de France. Michel Georgesco était un chercheur très

brillant, fils d'un ministre - évincé très tôt - du premier gouvernement

de la Roumanie libérée, et qui avait émigré en France pour assurer la

carrière chorégraphique de son épouse. Certains aspects de son activité

lui valurent de sérieux ennuis et, en fin de compte, une mort tragique

qui est demeurée très mystérieuse. Son ami Maurice Spighel était un

excellent expérimentateur muni de solides connaissances de chimie physique.

Tous deux orientèrent mes réflexions dans un sens plus concret, notre

objectif n'étant plus, dès lors, de construire coûte que coûte un modèle

d'où l'on puisse déduire - plus ou moins artificiellement - une équation

du type "Schrödinger", mais de mieux comprendre la nature

des processus atomiques élémentaires en identifiant les causes de leur

comportement aléatoire.

Pour nous, comme pour tous les "néo-classiques" que j'évoquais dans le premier document, les "anomalies" propres au domaine quantique étaient une manifestation de "stochasticité". Spighel était friand d'analogies empruntés à de nombreux domaines de la Science et de la Technique. Il connaissait l'instabilité de Rayleigh-Bénard et mentionnait des phénomènes de cinétique chimique entrainant l'apparition de structures spatiales périodiques. J'ignore quelles étaient ses sources, mais il me semble qu'il connaissait l'existence d'expériences du type de celle de Belousov, dont la théorie fut publiée ultérieurement par Zhaboutinski. Plus encore que Spighel, je me méfiais des projets de modélisation générale qui ne me semblaient pas réalistes. Déçu par les tentatives fondées sur une théorie "de la double solution" à la Bohm-Vigier (publiées en 1951 et 1952), comme par les modèles stochastiques qui ont été évoquées dans le premier document, je souhaitais maintenir notre effort dans le cadre spécifique de l'électrodynamique.

J'avais en effet remarqué que l'électrodynamique classique n'était pas sans présenter elle-même des anomalies. En particulier le calcul de l'énergie propre de l'électron dans le modèle de Lorentz débouchait sur des divergences que Dirac, Kramers, Weisskopf et d'autres avaient analysées sans les réduire. La réaction de rayonnement (la "force de Lorentz"), étant proportionnelle à la dérivée de l'accélération, donnait en effet, pour le calcul du mouvement de l'électron libre, des solutions dites "run-away" physiquement absurdes. Il semblait donc naturel, avant d'aborder le domaine quantique, de clarifier la situation dans le domaine classique, et c'est certainement ce qui motivait John A.Wheeler et Richard P.Feynmann, lorsqu'ils avaient proposé leur modèle de l'absorbeur, modèle qui - au prix d'une réinterprétation audacieuse de modèles plus anciens imaginés par Tetrode et Fokker - permettait d'élaborer une électrodynamique cohérente, c'est-à-dire libérée des divergences et possédant l'invariance relativiste [11] .

Conquis, lui aussi, par Wheeler et Feynmann, Christophe Tzara nous pressa d'adopter leur modèle et nous réalisâmes bientôt qu'en remplaçant la "complétude" stricte de l'absorbeur par une complétude "en moyenne" (la compensation entre actions avancées et actions retardées n'étant plus parfaite), nous pouvions justifier l'existence d'un résidu fluctuant qui corresponde exactement au "champ de zéro" envisagé depuis longtemps par Einstein et Stern. L'équation classique relativiste du mouvement (équation de Dirac) devient alors une équation différentielle stochastique à partir de laquelle il est possible d'effectuer des calculs (au moins dans l'approximation non-relativiste). Nos premiers résultats étaient encourageants puisqu'ils montraient la possibilité d'obtenir - dans le cadre classique - un résultat typiquement quantique : l'existence d'un état fondamental de l'oscillateur harmonique. Francis Perrin, alors Haut Commissaire à l'Energie Atomique, ne fit aucune difficulté pour présenter nos résultats à l'Académie des Sciences, au cours de la séance du 12 juillet. Voici le fac-simile de notre note :

Sur les conseils de Francis Perrin, cette note avait été rédigée avec beaucoup de prudence : elle s'inscrivait dans la rubrique "électrodynamique", comme une sorte de complément au "modèle de l'absorbeur" de Wheeler et Feynmann. La phrase essentielle du texte (p.2 du tiré-à-part) est "La liaison entre résistance de rayonnement et champ fluctuant est une liaison nécessaire" : c'est l'acte de naissance de l'Electrodynamique stochastique. Mais l'allusion à une réinterprétation de la théorie quantique demeure très indirecte. On souligne seulement que, dans le modèle proposé, l'oscillateur harmonique "acquiert une énergie moyenne qui ne dépend que du champ fluctuant et de r". Il s'agit bien de l'existence d'un "état fondamental", c'est-à-dire d'un phénomène caractéristique du domaine quantique. Mais le choix de l'énergie d'interaction comme base des calculs n'est pas justifié tandis que la forme du spectre K( ) reste inconnue : les risques de divergence demeurent.

Tzara résolut le problème du spectre pendant l'été 1954 dans le cadre d'une argumentation thermodynamique. Pour ma part je me familiarisai avec les méthodes "semi-classiques" d'élimination des divergences qu'à la suite de Weisskopf (1939), Welton et Feshbach (1948, 1949) venaient de mettre au point (et dont je n'appréciais d'ailleurs pas complètement la portée.)

Nous en déduisîmes cependant

une technique de calcul que nous eûmes le plaisir de retrouver dans

une communication d'Adirovitch et Podgoretskii, auteurs qui se plaçaient,

eux, dans le cadre d'une approche semi-classique. Nos résultats furent

présentés par Francis Perrin au cours de la séance du 20 décembre 1954.

En voici le fac-simile :

On note, dans ce qui précède, deux progrès importants, par rapport à la première note. Le premier est évidemment l'explicitation du spectre énergétique du "champ de zéro" (Tzara obtint un peu plus tard une autre démonstration fondée sur des considérations d'invariance relativiste, démonstration non publiée alors, mais retrouvée indépendemment et publiée par Marshall en 1965). Le second est le remplacement de "l'énergie d'interaction" par la somme "énergie cinétique + énergie potentielle", plus satisfaisante physiquement. Mais les calculs débouchent encore sur des intégrales divergentes et il devient nécessaire d'adopter une "procédure de soustraction" dont le caractère essentiellement heuristique peut paraître gênant.

Après une première tentative infructueuse, j'avais obtenu, en octobre 1954, d'être muté dans un service scientifique, le "Service des Constructions Electriques" (devenu plus tard "Département d'Electronique"), dirigé par Maurice Surdin. J'étais chargé de créer et d'animer un nouveau laboratoire consacré au Calcul Analogique Electronique dont les applications au Génie Nucléaire, et en particulier à l'analyse de la dynamique neutronique et de son contrôle étaient essentielles. Ceci me conduisit à m'investir sérieusement dans les domaines du Calcul Electronique et de la Mathématique Appliquée.

De leur côté Maurice Spighel et Christophe Tzara étaient amenés à s'engager plus complètement dans leurs laboratoires de physique expérimentale. Notre collaboration, et en premier lieu nos discussions relatives aux nouvelles publications dont nous avions connaissances ne cessèrent pas, mais s'espacèrent. En fait nous étions bien conscients d'avoir fait un pas dans la bonne direction, mais un pas seulement puisque notre technique de calcul ne permettait pas de déterminer les états excités d'un système élémentaire, oscillateur harmonique ou autre.

En août 1955, l'Organisation des Nations Unies prit l'initiative de convoquer à Genève une grande réunion de scientifiques et de techniciens consacrée aux Applications pacifiques de l'énergie nucléaire. J'avais proposé une communication qui présentait le travail de mon laboratoire et qui fut acceptée [12] . En arrivant à Genève, je découvris que Wheeler était l'un des conférenciers invités : il avait travaillé avec Bohr, en 1938 sur un modèle du noyau (modèle "de la goutte") qui était particulièrement adapté aux noyaux très lourds comme celui de l'uranium et était ainsi l'un des théoriciens les plus directement concernés par les problèmes de la réaction en chaîne contrôlée. Je réussis à le joindre et à obtenir un rendez-vous : un petit déjeuner à son hôtel en face du lac Léman!

Comme la plupart des universitaires et chercheurs américains, Wheeler était un homme extrêmement ouvert et chaleureux. Je lui montrai mes tirés-à-part et il entreprit d'effectuer quelques calculs sur une feuille de papier. Ces vérifications le satisfaisaient mais il n'avait visiblement jamais évalué les conséquences théoriques d'un modèle d'absorbeur fluctuant et il répugnait à le faire. Il avait du mal à se défaire du schéma qui était déjà devenu classique : théorie quantique = théorie classique + transformation canonique des variables en opérateurs, définis dans un espace de Hilbert, etc...

J'ai le sentiment aujourd'hui

qu'il avait été détourné d'une approche plus hétérodoxe par l'évolution

de Feynmann lui-même après l'achèvement de leur travail commun dans

l'immédiat avant-guerre [13] : lui aussi était victime, dans une certaine mesure,

de l'"effet Feynmann".

4. Les signaux et le guetteur

Pourtant mes convictions demeuraient intactes : les "anomalies"

de l'échelle atomique demeuraient pour moi une manifestation de situations

stochastiques dont il existait d'autres occurences dans la nature. Ces

anomalies n'impliquaient donc aucune limitation fondamentale de notre

connaissance. En cette période où les technologies de la communication

se développaient rapidement, il était clair que, comme Fürth l'avait

suggéré, il existait bien des bruits de fond, à chaque niveau

de l'échelle des phénomènes, mais qu'il était à chaque fois possible

d'en identifier la nature et d'en élaborer une formalisation.

Ces bruits imposaient évidemment des limitations à la précision des mesures, mais ne justifiaient pas pour autant qu'on attribuât à ces mesures l'existence même des phénomènes. J'eus l'occasion de défendre ce point de vue à l'occasion d'un congrès sur Les problèmes de la mesure,organisé par François Le Lionnais en décembre 1956. Voici le synopsis de ma communication :

ETUDE SUR

UN EXEMPLE DES PROBLEMES LIES A lA NOTION DE LIMITE "NATURELLE" DE LA PRECISION DES MESURES par P. BRAFFORT Ingénieur au Commissariat à l'Energie Atomique |

| L'existence d'une limitation pratique de la

précision des mesures est bien connue en

Physique, comme dans les autres sciences. Celle d'une limitation

de principe d'a été reconnue que plus récemment : - Limitations "quantiques" dans la description des phénomènes atomiques et subatomiques (Heisenberg 1924) - Limitations "thermiques" dans la description des phénomènes moléculaires et macroscopiques (en particulier lors des mesures électriques - Ising 1926). C'est dans cette deuxième direction qu'est apparue la notion d'une limite "naturelle" de la précision des mesures (Fürth 1933). Cette notion qui utilise les résultats de Gibbs, Einstein, Langevin, en théorie des fluctuations permet d'obtenir une formulation physique des problèmes de "principe" tels que : - La définition de "l'isolement" d'un système physique. - le calcul des grandeurs caractéristiques telles que l'énergie. - le rôle des niveaux de complexité des phénomènes d'interaction entre le système et son environnement. Ce point de vue est développé grâce à l'exemple de l'oscillateur harmonique classique : - Oscillateur macroscopique à la température T - oscillateur de Planck dans le "vide" On montre qu'il subsiste indépendemment de tout appareil de mesure, de tout observateur, une solidarité entre l'observateur et le reste de l'univers. Les notions de limite "naturelle" ou de limite "quantique" de la précision des mesures apparaissent alors comme des conséquences d'une description cohérente des phénomènes, compte tenu de l'impossibilité physique d'isoler jamais un système. Du coup certains faits "mystérieux" de la physique quantique prennent un aspect plus familier. |

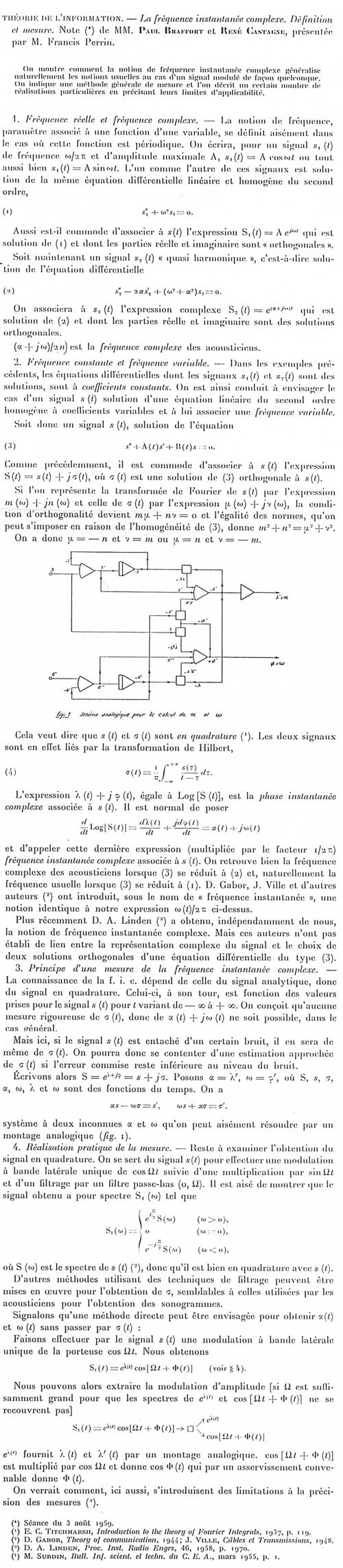

Toujours attentif au développement des travaux sur la Théorie de l'Information, j'avais lu avec intérêt les travaux de Jean Ville sur le signal analytique [14] . Il associait, à tout "signal" (c'est-à-dire à toute fonction d'une variable réelle qui pouvait être le temps), une fonction complexe qui, de plusieurs points de vue, ressemblait à la "fonction d'onde" de la mécanique ondulatoire.

Avec

l'aide d'un étudiant de l'ENSET, René Castanet, qui faisait un stage

dans mon laboratoire, je pus expliciter une notion qui me semblait intéressante,

celle de fréquence instantanée complexe. Nos résultats furent

publiés dans les Comptes Rendus de l'Académie des Sciences en août 1958.

Voici le fac-simile de notre communication :

5.

D'un aggiornamento à quelque inquiétude

L'étude du signal analytique nous avait bien permis d'introduire, avec la fréquence instantanée complexe, une notion intéressante; mais celle-ci s'avérait inopérante pour résoudre notre problème particulier. Je me lançai dans des recherches bibliographiques approfondies, en particulier dans les domaines de la thermodynamique et de la théorie de l'information et je bénéficiai pour cela des remarquables intuitions de Guy Mayer qui me présenta S. Machlup. Grâce à eux je fis connaissance avec les résultats d'Onsager sur la themodynamique des processus irréversibles. Mon projet, pourtant, restait en panne.

Depuis de nombreuses années j'avais conduit, en parallèle avec mon travail scientifique et technique, une activité de chanteur-compositeur (j'avais même "débuté" avec Jacques Brel au théâtre des trois Baudets en 1954). Un concours de circonstances m'amena à participer à un programme dans lequel les Frères Jacques passaient en vedette. Ce programme tînt l'affiche d'un cabaret de la Rive Gauche : la Fontaine des Quatre-Saisons, de septembre 1957 à mai 1958. Mes collègues du CEA n'apprèciaient guère cela et, sur le conseil de Francis Perrin, je demandai et obtins un congé sans solde. A la fin de ce congé je n'étais pas chaud pour reprendre la direction de mon laboratoire : Claude Caillet qui était auparavant mon adjoint l'assurait avec succès. Aussi je n'hésitai pas très longtemps lorsque je reçus des propositions pour partir à Bruxelles pour participer aux activités d'EURATOM.

La Communauté Européenne était entrée dans une phase de consolidation. EURATOM en était l'un de ses trois constituants et était dirigé par un président très dynamique, Etienne Hirsch qui avait été ministre dans le Gouvernement provisoire d'Alger, puis Commissaire au Plan. Son beau-frère, Jules Guéron, l'un des fondateurs du CEA, était Directeur Général de la Recherche. Guéron avait été directeur du Centre de Saclay et me connaissait bien. Il me proposa de le rejoindre pour monter une équipe de recherches sur l'Information Scientifique : Documentation et Traduction automatiques. Avec son aide et le soutien d'Etienne Hirsch, je mis en place à Bruxelles, puis à Ispra, une importante équipe pourvue de gros moyens de calcul : le CETIS (Centre Européen de Traitement de l'Information Scientifique). Nous eûmes ainsi la possiblilité de contribuer de façon significative au développement, en Europe, d'une discipline nouvelle : l'Intelligence Artificielle [15] .

Cela impliquait un apprentissage de disciplines telles que la logique et la linguistique ainsi qu'un effort suplémentaire en Théorie de l'Information ainsi que dans ce domaine nouveau qui n'avait pas encore reçu le nom d'Informatique. Je n'oubliai pas pour autant les processus stochastiques dont j'étudiai, en collaboration avec Jean Larisse, des instances particulières. [16]

Le départ d'Etienne Hirsch, consécutif à un conflit avec de Gaulle, ouvrit une période de règlements de compte où Jules Guéron était visé et qui m'atteignit indirectement (le prétexte de ma disgrâce étant fourni par les services de Sécurité du CEA, alors qu'EURATOM était exempt de toute activité militaire!) [17] Malgré l'aide d'un ami qui était déjà un juriste éminent [18] , je dus revenir au CEA où je n'avais plus d'affectation précise.

Pendant ce temps une nouvelle organisation scientifique internationale avait vu le jour : l'ESRO (Organisation Européenne de Recherches Spatiales, aujourd'hui Agence Spatiale Européenne). Un laboratoire de recherches était en construction à Noordwijk (Pays-Bas) : l'ESTEC (European Space Technology Centre). Maurice Surdin était le chef du département "Développement et Technologie". En octobre 1964, il me recruta comme chef de la Divivion de "Contrôle dynamique", petite équipe dont j'étendis bientôt les compétences pour en faire une "Division de Mathématique Appliquée" disposant d'importants moyens de calcul. J'étais alors trop occupé par ma nouvelle responsabilité à laquelle s'ajoutait la mise au point de mon livre-bilan des années d'EURATOM, pour reprendre immédiatement mes recherches sur l'électrodynamique stochastique, malgré les facilités que nous offraient les bibliothèques de Delft et de Leiden (en particulier la bibliothèque du Lorentz Instituut).

Un jour pourtant Surdin me convoqua pour me montrer le dernier numéro de Philosophical Magazine qui contenait un article de Trevor Marshall. Celui-ci développait un raisonnement et présentait des résultats très semblables à ceux que nous avions obtenus en 1954. Je me préparai à lui envoyer nos tirés-à-part, mais Surdin insista pour que je me remette au travail. Mon équipe venait de s'enrichir d'un jeune mathématicien italien, Adolfo Taroni, que ces problèmes intéressaient et nous pûmes obtenir de nouveaux résultats. Puis Surdin lui-même se joignit à nous et demeura dès lors attaché au domaine de l'électrodynamique stochastique et ce fut le début d'une négociation (assez pénible) pour la publication de nos résultats. Surdin avait souhaité que présentions nos travaux par l'intermédiaire d'Alfred Kastler. A notre grande surprise, celui-ci fut extrêmement réticent et se réfugia derrière les avis d'experts dont les commentaires montraient qu'ils n'avaient pas vraiment lu notre texte. L'un d'entre eux, Albert Messiah, aui avait été notre collègue au CEA - et qui était aussi l'auteur d'un remarquable traité [19] - n'admettait pas que le dogme copenhagien soit remis en cause [20] . Au bout de quelques semaines, Kastler s'en remit à l'opinion de Jacques Yvon qui avait été le chef du Service de Physique Mathématique à Saclay et qui déclara que bien que ne croyant pas à la valeur de notre travail, il trouvait normal de le publier puisque des approches semblables étaient adoptées par les anglo-saxons (!) Parmi les commentaires dont Kastler nous fit parvenie la copie, je relève les suivants :

..., l'idée de résoudre certaines difficultés de l'électrodynamique classique en introduisant un champ fluctuant aléatoire [sic] ne me semble pas saine. on ne résout pas les difficultés d'une théorie fondamentale en introduisant artificiellement des probabilités. De toute façon, il s'agit d'un problème académique, puisque l'électrodynamique classique n'est, elle-même, qu'une approximation de l'électrodynamique quantique...1°) Je ne pense pas que malgré les travaux relatifs à l'électrodynamique quantique initiés par les derniers prix Nobel [Tomonaga, Schwinger, Feynmann], le sujet soit épuisé. Les questions liées à la renormalisation restent pénibles.2°) Je pense que la mécanique statistique et ses procédés permettront d'éclaircir un certain nombre de points.3°) C'est un peu ce que proposent les auteurs des notes précitées. Ils ont donc, à mon avis, un point de départ judicieux.4°) Le fait d'aborder la question dans une ambiance classique et non quantique est, par contre, une regrettable restriction : les vrais fondements de la mécanique statistique sont quantiques.

Ce dernier commentaire (dû, je crois, à Yvon) emporta la décision.

Nous avions préparé trois

notes, qu'il nous fallut réduire à une seule, présentée à l'Académie

des Sciences par Alfred Kastler, le 22 novembre 1965 - où, pour la première

fois, nous utilisions l'expression "électrodynamique aléatoire"

empruntée à Marshall - et reproduite ci-dessous :

Le progrès accompli correspondait à une simple amélioration de nos anciens calculs : en prenant un terme de plus dans le développement de la primitive de

on trouve un terme en q1/2 log q, c'est-à-dire de la même forme que la correction "effet Lamb" en électrodynamique quantique (multiplié cependant par un facteur 3 bien embarrassant!) Par ailleurs si l'on utilisait, comme formule d'énergie, celle de la première note et non plus celle de la deuxième, la terme supplémentaire était encore de la même forme (multiplié par -2, cette fois!) Or Adolfo Taroni avait remarqué l'utilisation, dans un calcul "semi-classique" de Sokolov, d'un "moment" non-orthodoxe, qui était la somme des deux termes en question, et que nous baptisâmes "moment électro-cinétique". On obtenait ainsi tout à la fois une meilleure cohérence conceptuelle, des intégrales convergentes et une valeur correcte de l'effet Lamb.

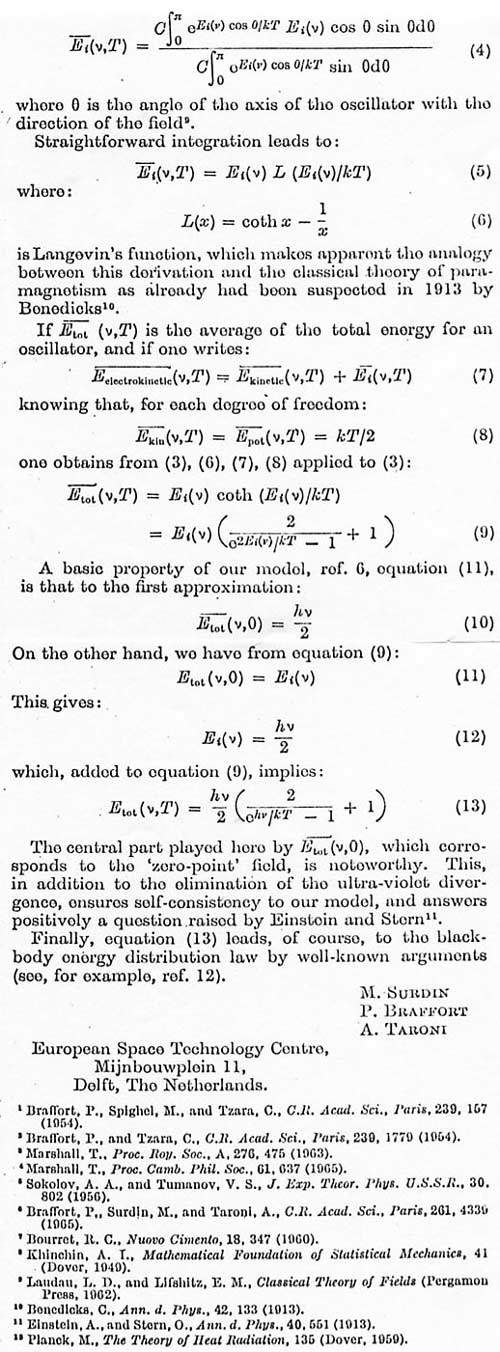

Ce résultat nous encouragea

à développer notre modèle et à en explorer les conséquences dans les

divers domaines relevant de la théorie quantique. La formule de Planck

pour le rayonnement du "corps noir", étant à l'origine même

de la nouvelle théorie, formait un sujet de réflexion idéal. Nous n'eûmes

pas de difficulté à publier nos résultats dans Nature, le 22

avril 1966. Voici le fac-simile du texte de notre communication :

Notre présentation de la formule de Planck, inspirée par Benedicks,

trouvait ainsi un emploi inédit à la fonction de Langevin : L (x)

= coth x - 1/x. Mais notre calcul dépendait de la validité de la formule

(7), conjecture vraisemblable, mais non démontrée.

En même temps, nous poursuivions notre étude des corrections "fines" de l'électrodynamique quantique, en les réinterprétant dans notre modèle. Les résultats obtenus furent énoncés dans la note reproduite ci-après, note présentée à l'Académie des Sciences le 22 mai 1967 :

Les résultats ainsi obtenus étaient encourageants dans la mesure où ils établissaient un lien très précis entre l'électrodynamique stochastique et l'électrodynamique quantique, et ceci jusque dans certaines de ses prédictions les plus fines. En même temps le modèle physique qui sous-tendait notre approche et nos calculs s'appuyait sur une interprétation de l'électrodynamique (le modèle de l'absorbeur) que l'on pouvait contester mais qui permettait d'éviter des spéculations méthodologiques ou épistémologiques telles que le principe de complémentarité ou la "théorie" de la mesure.

Mais toutes ces confirmations n'étaient que partielles dans la mesure où nous ne pouvions déduire de notre modèle certains des résultats les plus élémentaires relatifs de la théorie quantique relatifs aux processus atomiques et moléculaires et à leur dynamique : nous proposions un calcul correct de l'effet Lamb ou du moment magnétique anormal, mais les formalismes de Schrödinger ou de Heisenberg-Jordan demeuraient hors de notre portée. Nous pouvions calculer le niveau fondamental s'un système, mais pas les niveaux excités! Or c'était évidemment là une condition nécessaire à l'établissement de notre crédibilité comme à l'exploration de nouveaux domaines d'application de notre théorie.

Et pourtant, même incomplète, l'électrodynamique stochastique voyait peu à peu son statut se consolider et les publications se multiplier. Visiblement le Philosophical Magazine avait plus de lecteurs que les Comptes-Rendus de l'Académie des Sciences! Timothy Boyer, Luis de la Peña-Auerbach, Emilio Santos - et Surdin lui-même - apportèrent alors une contribution importante à ces développements. C'était le début d'une production qui s'est poursuivie jusqu'à ce jour et dont j'ai analysé le contenu et la portée dans le premier document de ce dossier.

De mon côté, et malgré les progrès accomplis par Marshall, Boyer et d'autres, j'avais le sentiment que la SED (pour Stochastic ElectroDynamics) n'était pas engagée dans la bonne voie. Je me livrai alors à un examen récapitulatif de la littérature afin d'identifier l'obstacle ou les obstacles réellement fondamentaux, obstacle dont je pressentais qu'ils avaient une double origine : physique et mathématique.

J'acquis ainsi la conviction qu'il ne s'agissait pas là d'obstacles véritablement "conceptuels", mais plutôt de difficultés de nature essentiellement technique. Je n'étais pas capable de les résoudre mais je m'efforçai au moins de les identifier et ce fut l'objet de la dernière note de cette série, note qui fut présentée le 5 janvier 1970 et que je reproduis ci-après en fac-simile :

La réception que reçoivent les publications scientifique est extrêmement variable (oserai-je dire "aléatoire"?) Elle dépend de beaucoup de facteurs : actualité de la recherche, statut académique du chercheur, langue et statut de la publication, etc... Alors que nos publications de 1954, celles de Saclay, étaient passées inaperçues (et en premier lieu inaperçues de Trevor Marshall), celles de Noordwijk furent lues et commentées abondamment. Nous reçûmes en particulier de nombreuses demandes de tirés-à-part et certains de nos correspondants s'engagèrent résolument dans le développement de l'électrodynamique stochastique (j'en ai rendu compte dans le document 1, chapitre 5). De la Peña-Auerbach alla jusqu'à parler de "l'équation de Braffort-Langevin", Thomas Brody de "l'équation de Braffort-Marshall", etc...

Par contre personne ne

fit écho à ma note de 1970. Surdin quitta l'Estec

pour l'Université de Bordeaux, Taroni rejoignit l'Université de Bologne

et je fus moi-même nommé à Paris-Sud (Université de Paris XI) pour

y enseigner l'informatique. Ces événements interrompirent à nouveau

- et durablement - mon activité dans le domaine de la physique théorique.

6. Leçons américaines et autres

Pendant plusieurs années mon activité de recherche, localisée au département

de mathématique du Centre d'Orsay s'orienta vers la logique mathématique

- principalement la logique combinatoire et le lambda-calcul. Avec

l'aide de Michel Demazure et l'encouragement de Georges Poitou, une

équipe fut rassemblée dans le cadre d'un séminaire baptisé "ECSTASM"

(Essai de Constitution d'un Système de Traitement Automatique du Symbolisme

Mathématique). cette activité déboucha sur la constitution d'un laboratoire

associé au CNRS, le laboratoire "Al Khowarizmi",

sur l'invitation de plusieurs professeurs étrangers (Ken Iverson,

puis N.G. De Bruijn) et l'organisation, à Orsay, d'un séminaire consacré

à la manipulation des symboles assistée par ordinateur.

Un malheureux concours de circonstances me contraignit alors à quitter l'université pour m'engager dans l'industrie des services informatiques. A vrai dire je ne m'y sentais pas vraiment à l'aise et surtout je n'avais plus guère de loisirs pour suivre l'actualité scientifique, en particulier dans le domaine de la Physique. J'appréciai donc la possibilité qui me fut donnée, en 1983, de reprendre mes chères études...

Depuis plusieurs années mon activité en Informatique m'avaient conduit à effectuer un retour vers la linguistique - via la littérature. En 1961, sur la recommandation de Raymond Queneau et François Le Lionnais, j'avais été coopté au sein de l'OULIPO (Ouvroir de Littérature Potentielle). Dès le milieu des années soixante-dix, il devenait possible de développer des présentations informatiques de certaines constructions littéraires combinatoires telles que les Cent mille milliards de poèmes de Queneau. En 1981, cette activité avait pris suffisemment d'ampleur pour qu'une nouvelle association soit fondée, l'ALAMO (Atelier de Littérature Assistée par la Mathématique et les Ordinateurs). J'y consacrai alors une grande partie de mon activité, renouant à cette occasion avec les bibliothèques scientifiques d'Orsay et de Saclay.

L'Alamo organisait, un peu partout en France (et même en Suisse et en Belgique) des ateliers et des démonstrations. Je fis ainsi la connaissance, au printemps de 1988, d'un professeur à l'Université de Chicago intéressé par ce que les anglo-saxons appellent "computational linguistics". Il m'obtint une invitation comme "visiting scholar" et je m'installai là-bas pour deux ans (mon bureau était à cinquante mètres de la sculpture de Moore, à l'emplacement où fut réalisée, en 1942, la première expérience "nucléaire" par Fermi, Szilard et leur équipe.)

Mais la Graduate Library School dont j'étais l'hôte était en pleine crise. Elle laissait bientôt la place à un Committee for Information and Language Studies sans grands moyens et malgré mes efforts pour organiser une collaboration avec d'autres équipes (celles de Maurice Gross à Paris VII et celle de Peter Hellwig à Heidelberg) les choses n'avançaient que très lentement.

Je décidai de profiter des merveilleuses ressources qu'offrent les bibliothèques universitaires américaines et de mettre à jour ma documentation. Mon bureau se trouvait dans le bâtiment même de la Joseph Regenstein Library, consacrée aux Humanités : Littérature, Philosophie, Histoire, etc.. Puis je découvris la John Crerar Library où se trouvent en abondance ouvrages et périodiques scientifiques. Grâce à Etienne Guyon, je fis la connaissance d'Albert Libchaber qui habitait en face de chez moi, dans la cinquantième rue et étudiait avec Léo Kadanoff l'apparition de structures spatiales dans un volume d'hélum liquide soumis à un gradient de température. Le livre de James Gleick : Chaos venait de paraître et la "dynamique non-linéaire" était en plein essor. Je retrouvai ainsi une problématique que j'avais effleurée, trente ans plus tôt, lorsque j'étudiais la dynamique neutronique des réacteurs nucléaires. Je découvris les "attracteurs étranges" et retrouvai les "fractales" de mon vieil ami Benoît Mandelbrot.

En même temps je pris conscience de l'actualité nouvelle qu'avaient prises les discussions relatives au fondement de la théorie quantique. Dans le premier document de ce dossier (et en particulier dans le dernier chapitre) j'ai indiqué comment le débat s'était cristallisé autour de la fameuse expérience de pensée "EPR" - ou plutôt du rebondissement causé par les travaux de Bell et les expériences qui suivirent (et se poursuivent aujourd'hui.) Je m'efforçai cependant d'élargir le champ de ma documentation en examinant systématiquement les tentatives non-orthodoxes que l'on pouvait découvrir, ici et là, dans la littérature. C'est ainsi que je me suis particulièrement intéressé aux suggestions d'Adrian Patrascioiu, qui avait été un collaborateur de Stanislaw Ulam, et qui proposait une analyse très fine de l'hypothèse ergodique et de l'utilisation du principe d'équipartition, analyse qui remettait en question les formes traditionnelles de la théorie du rayonnement thermique. J'examinai aussi avec intérêt certains développement de la technique en physique mathématique et en mathématique appliquée, en particulier celle des "twistors" de Roger Penrose et celle des "ondelettes" imaginée par Morlet, Daubechies, Grossmann, et dont la théorie était développée par Yves Meyer.

De retour en France, je fus amené à accepter une responsabilité de consultant dans une équipe (le CIMA) attachée au Ministère de l'équipement et de l'urbanisme et travaillant dans le domaine de la "conception assistée par ordinateur", avant d'être nommé Directeur de programme au Collège International de Philosophie. Mais j'étais décidé à ne plus abandonner ce qui avait été mon premier pari scientifique, et j'entrepris et de reprendre, ou plutôt de poursuivre [21] , avec plus de système, mon enquête.

Un nouveau séjour à Chicago, suivi de la lecture du livre de Thomas Brody (évoqué plus haut), achevèrent de me déterminer. Je n'avais évidemment pas la possibilité d'accomplir moi-même la totalité du travail dont je discernais mieux, désormais, les difficultés comme les promesses. La solution d'un "dossier de travail" s'imposait donc et cette vision "réflexive" clôt naturellement, je pense, ce deuxième document en forme de confession.

[12] Les problèmes dynamiques du réacteur de puissance et les machines analogiques. Ce travail fit aussi l'objet d'une publication séparée comme rapport CEA n°432 (1955).

[13]Cela me semble clair à la lecture du livre de James Gleick : Genius, Richard Feynmann and modern physics.Little, Brown, 1992, en particulier pp. 106 et suivantes.

[15] J'en présentai un bilan dans un livre préfacé par Jules Guéron : L'intelligence artificielle; Presses Universitaires de France, 1968 (le premier sur ce sujet, malheureusement publié à un bien mauvais moment!).

[16] Cf. Equations différentielles stochastiques régissant l'évolution de la densité neutronique dans un milieu multiplicateur (Journal of Nuclear Energy 13 1960, p.133) ainsi que La diffusion des erreurs en analysenumérique; étude d'un modèle stochastique et applications à quelques cas particuliers. (1er Congrès de l'AFCALTI, 1960).

[20] Sans doute n'admettait-il pas non plus qu'un tel sacrilège soit commis par quelqu'un qui n'était après tout qu'un amateur ayant de surcroît mené une carrière de chanteur-compositeur, si brève fût-elle!

[21] Le mot anglais resume exprime, mieux sans doute que les deux verbes que je viens d'utiliser, ce travail.